딥러닝 및 거대 언어 모델용 GPU 선택 방법

딥러닝 워크로드, 특히 거대 언어 모델(LLMs) 학습 및 실행을 위한 GPU를 선택할 때는 여러 요소를 고려해야 합니다. 올바른 선택을 위한 종합 가이드입니다.

표: 최신 주요 오픈 소스 LLMs와 로컬 배포를 위한 GPU 요구사항

| 모델 | 매개변수 | VRAM 요구사항 | 추천 GPU |

|---|---|---|---|

| DeepSeek R1 | 671B | ~1,342GB | NVIDIA A100 80GB ×16 |

| DeepSeek-R1-Distill-Qwen-1.5B | 1.5B | ~0.7GB | NVIDIA RTX 3060 12GB+ |

| DeepSeek-R1-Distill-Qwen-7B | 7B | ~3.3GB | NVIDIA RTX 3070 8GB+ |

| DeepSeek-R1-Distill-Llama-8B | 8B | ~3.7GB | NVIDIA RTX 3070 8GB+ |

| DeepSeek-R1-Distill-Qwen-14B | 14B | ~6.5GB | NVIDIA RTX 3080 10GB+ |

| DeepSeek-R1-Distill-Qwen-32B | 32B | ~14.9GB | NVIDIA RTX 4090 24GB |

| DeepSeek-R1-Distill-Llama-70B | 70B | ~32.7GB | NVIDIA RTX 4090 24GB ×2 |

| Llama 3 70B | 70B | ~140GB (예상) | NVIDIA 3000 시리즈, 최소 32GB RAM |

| Llama 3.3 (소형 모델) | 다양 | 최소 12GB VRAM | NVIDIA RTX 3000 시리즈 |

| Llama 3.3 (대형 모델) | 다양 | 최소 24GB VRAM | NVIDIA RTX 3000 시리즈 |

| GPT-NeoX | 20B | 총 48GB+ VRAM | NVIDIA RTX 3090 2개 (각 24GB) |

| BLOOM | 176B | 학습용 40GB+ VRAM | NVIDIA A100 또는 H100 |

GPU 선택 시 주요 고려사항

1. 메모리 요구사항

- VRAM 용량: LLMs에 있어 가장 중요한 요소일 수 있습니다. 모델이 클수록 매개변수, 기울기, 옵티마이저 상태, 캐시된 학습 샘플 등을 저장하기 위해 더 많은 메모리가 필요합니다.

표: 거대 언어 모델(LLMs)에서 VRAM의 중요성

| 측면 | VRAM의 역할 | 핵심 이유 | 부족할 경우 영향 |

|---|---|---|---|

| 모델 저장 | 모델 가중치 및 레이어 보유 | 효율적인 처리에 필수적 | 느린 메모리로 오프로드; 성능 크게 저하 |

| 중간 계산 | 활성화 값 및 중간 데이터 저장 | 실시간 순방향/역방향 계산 가능케 함 | 병렬 처리 제한 및 지연 시간 증가 |

| 배치 처리 | 더 큰 배치 크기 지원 | 처리량 및 속도 향상 | 작은 배치; 학습/추론 속도 저하 |

| 병렬 처리 지원 | GPU 간 모델/데이터 병렬 처리 가능케 함 | 매우 큰 모델(예: GPT-4)에 필수적 | 여러 GPU 간 확장성 제한 |

| 메모리 대역폭 | 고속 데이터 접근 제공 | 행렬 곱셈과 같은 계산 집약적 작업 가속 | 계산 집약적 작업의 병목 현상 발생 |

- 필요 용량 계산: 모델 크기와 배치 크기를 기반으로 메모리 요구사항을 예상할 수 있습니다.

- 메모리 대역폭: 대역폭이 높을수록 GPU 메모리와 처리 코어 간의 데이터 전송이 빠릅니다.

2. 컴퓨팅 성능

- CUDA 코어: 코어 수가 많을수록 일반적으로 병렬 처리가 빨라집니다.

- 텐서 코어: 행렬 연산에 특화되어 있으며, 딥러닝 작업에 중요합니다.

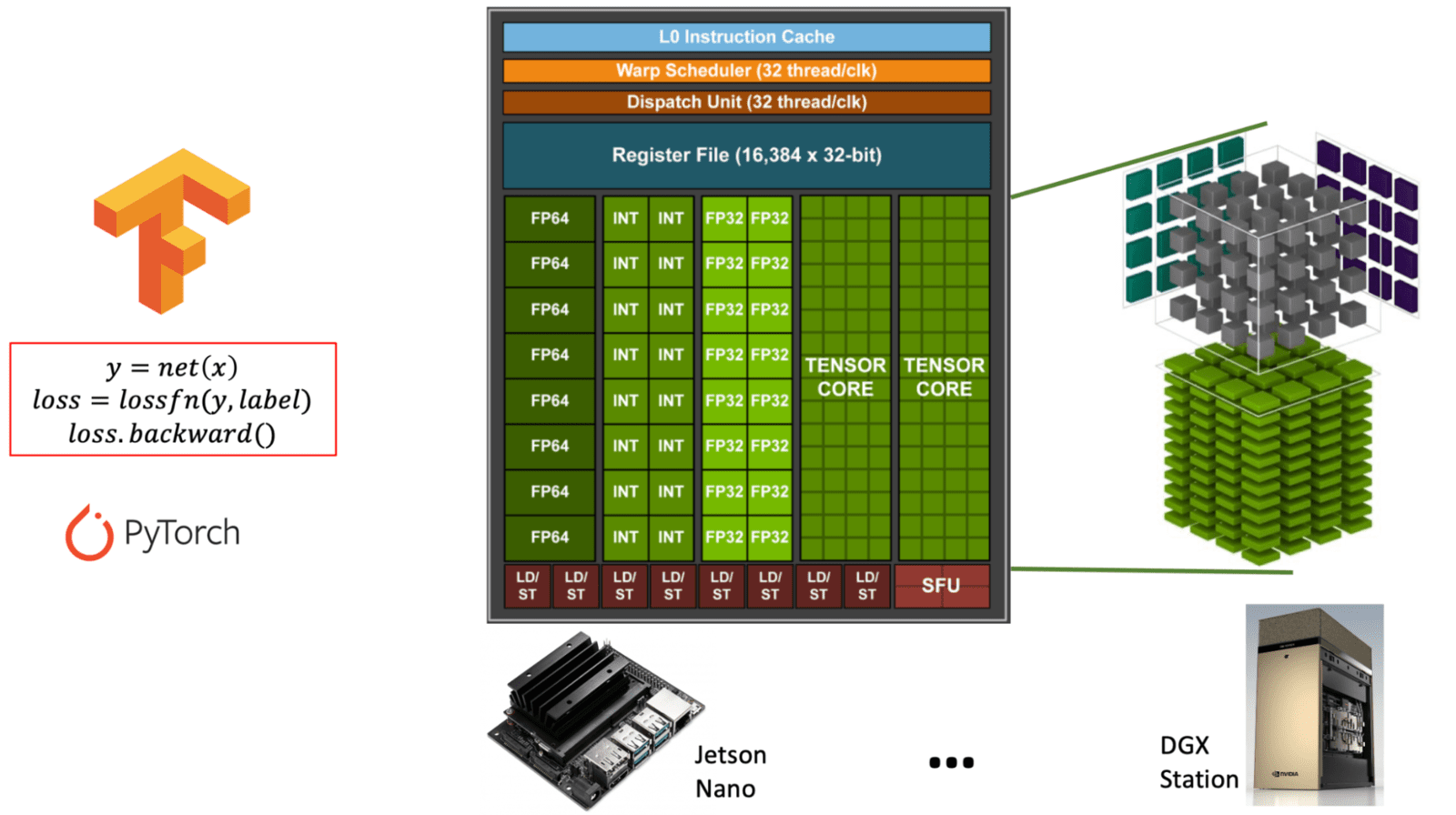

NVIDIA GPU 아키텍처 내 범용 CUDA 코어와 특수 텐서 코어의 차이를 보여주는 다이어그램입니다. (learnopencv.com) - FP16/INT8 지원: 혼합 정밀도 학습은 메모리 사용량을 줄이면서 계산 속도를 크게 높일 수 있습니다.

표: NVIDIA GPU의 CUDA 코어 vs 텐서 코어 비교. 이 표는 CUDA 코어와 텐서 코어의 목적, 기능 및 사용법을 설명하며, AI 및 딥러닝과 같은 다양한 GPU 워크로드에 모두 필수적입니다.

| 특징 | CUDA 코어 | 텐서 코어 |

|---|---|---|

| 목적 | 범용 컴퓨팅 | 행렬 연산(텐서 수학)에 특화 |

| 주요 용도 | 그래픽, 물리 연산, 표준 병렬 작업 | 딥러닝 작업(학습/추론) |

| 연산 | FP32, FP64, INT, 일반 산술 연산 | 행렬 곱셈-누적 (예: FP16, BF16, INT8) |

| 정밀도 지원 | FP32 (단정밀도), FP64 (배정밀도), INT | FP16, BF16, INT8, TensorFloat-32 (TF32), FP8 |

| 성능 | 범용 작업에 적절한 성능 | 행렬 집약적 작업에 대해 매우 높은 성능 |

| 소프트웨어 인터페이스 | CUDA 프로그래밍 모델 | cuDNN, TensorRT 또는 프레임워크(예: PyTorch, TensorFlow)와 같은 라이브러리 통해 접근 |

| 가용성 | 모든 NVIDIA GPU에 존재 | 최신 아키텍처(Volta 이상)에만 존재 |

| AI 최적화 | 제한적 | AI 워크로드에 고도로 최적화됨 (10배 이상 빠를 수 있음) |

3. GPU 간 통신

- NVLink: 다중 GPU 설정을 사용하는 경우 NVLink는 PCIe보다 훨씬 빠른 GPU 간 통신을 제공합니다.

NVLink는 NVIDIA가 개발한 고속 인터커넥트 기술로, GPU 간(때로는 GPU와 CPU 간) 빠른 통신을 가능하게 합니다. 전통적인 PCIe(Peripheral Component Interconnect Express)의 한계를 극복하고 훨씬 높은 대역폭과 낮은 지연 시간을 제공합니다.

표: NVLink 브리지 및 목적 개요. 이 표는 AI 및 고성능 워크로드에 대한 GPU 기반 컴퓨팅 맥락에서 NVLink의 기능, 이점 및 주요 사양을 설명합니다.

| 특징 | NVLink |

|---|---|

| 개발사 | NVIDIA |

| 목적 | 여러 GPU 간의 빠르고 직접적인 통신 가능케 함 |

| 대역폭 | 최신 버전(예: NVLink 4.0)에서 총 600 GB/s까지 가능 |

| PCIe 대비 | 훨씬 빠름 (PCIe 4.0: 총 ~64 GB/s) |

| 지연 시간 | PCIe보다 낮음; 다중 GPU 효율성 향상 |

| 사용 사례 | 딥러닝(LLMs), 과학 계산, 렌더링 |

| 작동 방식 | GPU 연결을 위해 NVLink 브리지(하드웨어 커넥터) 사용 |

| 지원 GPU | 고급 NVIDIA GPU (예: A100, H100, 제한적인 RTX 3090) |

| 소프트웨어 | CUDA-aware 애플리케이션 및 프레임워크와 함께 작동 |

| 확장성 | 여러 GPU가 마치 하나의 큰 GPU처럼 작동하게 함 |

LLMs 및 AI에 NVLink가 중요한 이유

- 모델 병렬 처리: 대형 모델(예: GPT 스타일 LLMs)은 단일 GPU에 비해 너무 큽니다. NVLink는 GPU가 메모리와 작업 부하를 효율적으로 공유하도록 합니다.

- 더 빠른 학습 및 추론: 통신 병목 현상을 줄여 다중 GPU 시스템의 성능을 향상시킵니다.

- 통합 메모리 접근: PCIe에 비해 GPU 간 데이터 전송을 거의 원활하게 만들어 동기화 및 처리량을 향상시킵니다.

- 다중 카드 학습: 여러 GPU에 분산 학습을 수행할 때 통신 대역폭이 매우 중요해집니다.

요약표: 분산 학습에서 GPU 간 통신의 중요성

(표: 분산 학습에서 GPU 간 통신의 역할. 이 표는 빠르고 효율적인 딥러닝 모델 학습 확장을 위해 GPU 간 통신이 필요한 부분과 그 중요성을 설명합니다.)

| 분산 학습 작업 | GPU 간 통신이 중요한 이유 |

|---|---|

| 기울기 동기화 | 데이터 병렬 설정에서 일관성 및 수렴 보장 |

| 모델 샤딩 | 모델 병렬 아키텍처에서 원활한 데이터 흐름 가능케 함 |

| 매개변수 업데이트 | GPU 간 모델 가중치 동기화 유지 |

| 확장성 | 추가 GPU 또는 노드의 효율적인 사용 가능 |

| 성능 | 학습 시간 단축 및 하드웨어 활용 극대화 |

4. 전력 소비 및 냉각

- TDP(열 설계 전력): 고성능 GPU일수록 더 많은 전력을 필요로 하고 더 많은 열을 발생시킵니다.

- 냉각 솔루션: 여러 고성능 GPU의 열 출력을 감당할 수 있는 냉각 시스템을 갖추세요.

인기 GPU 옵션 비교

표: 딥러닝용 NVIDIA GPU 기능 비교. 이 표는 RTX 4090, RTX A6000, RTX 6000 Ada의 주요 사양과 기능을 비교하며, 딥러닝 워크로드에 대한 강점을 보여줍니다.

| 특징 | RTX 4090 | RTX A6000 | RTX 6000 Ada |

|---|---|---|---|

| 아키텍처 | Ada Lovelace | Ampere | Ada Lovelace |

| 출시 연도 | 2022 | 2020 | 2022 |

| GPU 메모리 (VRAM) | 24 GB GDDR6X | 48 GB GDDR6 ECC | 48 GB GDDR6 ECC |

| FP32 성능 | ~83 TFLOPS | ~38.7 TFLOPS | ~91.1 TFLOPS |

| 텐서 성능 | ~330 TFLOPS (FP16, 희소성 활성화) | ~312 TFLOPS (FP16, 희소성) | ~1457 TFLOPS (FP8, 희소성) |

| 텐서 코어 지원 | 4세대 (FP8 포함) | 3세대 | 4세대 (FP8 지원) |

| NVLink 지원 | ❌ (NVLink 없음) | ✅ (2-way NVLink) | ✅ (2-way NVLink) |

| 전력 소비 (TDP) | 450W | 300W | 300W |

| 폼 팩터 | 소비자용 (2슬롯) | 워크스테이션용 (2슬롯) | 워크스테이션용 (2슬롯) |

| ECC 메모리 지원 | ❌ | ✅ | ✅ |

| 주요 시장 | 애호가 / 프로슈머 | 전문가 / 데이터 과학자 | 기업 / AI 워크스테이션 |

| 권장 소비자 가격 (약) | $1,599 USD | $4,650 USD | ~$6,800 USD (판매사별 상이) |

RTX 4090

- 아키텍처: Ada Lovelace

- CUDA 코어: 16,384개

- 메모리: 24GB GDDR6X

- 장점: 가격 대비 성능 비율이 가장 높음, 단일 GPU 작업에 탁월

- 제한 사항: NVLink 미지원, 전문가용 옵션보다 메모리 적음

- 가장 적합한 경우: 중간 크기 모델의 단일 GPU 학습, 예산 제약이 있는 연구자

RTX A6000

- 아키텍처: Ampere

- CUDA 코어: 10,752개

- 메모리: 48GB GDDR6

- 장점: 대용량 메모리, NVLink 지원, 전문가 등급 안정성

- 제한 사항: 최신 카드보다 낮은 순수 성능

- 가장 적합한 경우: 메모리 집약적 작업, NVLink가 필요한 다중 GPU 설정

RTX 6000 Ada

- 아키텍처: Ada Lovelace

- CUDA 코어: 18,176개

- 메모리: 48GB GDDR6

- 장점: 최신 아키텍처와 대용량 메모리, NVLink 결합

- 제한 사항: 높은 가격

- 가장 적합한 경우: 예산이 주요 고려사항이 아닌 타협 없는 설정

특수 하드웨어 옵션

SXM 폼 팩터 GPU

표: GPU의 SXM vs PCIe 폼 팩터 비교. 이 표는 딥러닝, HPC, 데이터 센터 애플리케이션에 대한 SXM과 표준 PCIe의 주요 차이점과 이점을 설명합니다.

| 특징 | SXM 폼 팩터 | PCIe 폼 팩터 |

|---|---|---|

| 연결 유형 | 직접 소켓 인터페이스 (PCIe 슬롯 통하지 않음) | PCIe 슬롯에 삽입 |

| 전력 공급 | GPU당 **700W+**까지 가능 | 일반적으로 300–450W로 제한 |

| 냉각 설계 | 맞춤형 방열판, 액체 냉각 옵션 통한 최적화 냉각 | 표준 팬을 통한 공랭식 |

| 대역폭/지연 시간 | 높은 대역폭과 낮은 지연 시간을 가진 NVLink 지원 | PCIe 버스 속도로 제한 |

| GPU 인터커넥트 | 여러 GPU 간 고대역폭 NVLink 메시 | PCIe 통한 저대역폭 피어-투-피어 통신 |

| 크기 및 통합 | 고밀도 서버 환경(예: NVIDIA HGX) 설계 | 워크스테이션 또는 표준 서버 랙에 적합 |

| 성능 확장성 | 다중 GPU 구성에 탁월 | PCIe 버스 및 전력 제약으로 제한 |

| 주요 사용 사례 | 데이터 센터, AI 학습, HPC, 클라우드 플랫폼 | 데스크톱, 워크스테이션, 경량 엔터프라이즈 작업 |

- 옵션: V100, A100, H100 (SXM2/SXM4/SXM5 커넥터 사용)

- 장점: PCIe 버전보다 높은 전력 제한 및 대역폭

- 사용처: NVIDIA DGX 시스템과 같은 고성능 서버 플랫폼

다중 노드 솔루션

- 노드당 4~8개 GPU를 지원하는 서버 플랫폼

- 예: Dell C4140, Inspur 5288M5, GIGABYTE T181-G20

의사결정 프레임워크

- 메모리 요구사항을 먼저 파악하세요

- 모델이 메모리에 맞지 않으면 성능은 의미가 없습니다. 표: 딥러닝에서 OOM (Out-Of-Memory) 오류 이해. 이 표는 OOM 오류의 원인, 발생 이유, GPU 메모리 제한이 모델 학습 및 추론에 미치는 영향을 설명합니다.

| 측면 | 설명 |

|---|---|

| OOM이란? | "메모리 부족" 오류 - 모델이나 배치가 GPU VRAM에 맞지 않을 때 발생합니다. |

| 근본 원인 | 모델 가중치, 활성화 값, 데이터가 사용 가능한 GPU 메모리를 초과합니다. |

| 발생 시점 | 모델 초기화, 순방향 계산, 역전파, 대형 배치 로드 중에 발생합니다. |

| 영향 받는 구성 요소 | 모델 매개변수, 옵티마이저 상태, 활성화 맵, 기울기. |

| GPU 메모리 (VRAM) | 모델의 크기나 복잡성을 결정하는 유한한 자원입니다. |

| 첫 번째 확인 사항 | 항상 모델 크기 + 배치 요구사항을 사용 가능한 VRAM과 비교해야 합니다. |

| 일반적인 유발 요인 | - 모델이 너무 큼 - 배치 크기가 너무 큼 - 혼합 정밀도 사용 안 함 - 메모리 누수 |

| 해결 전략 | - 모델 크기 축소 - 배치 크기 감소 - 기울기 체크포인트 사용 - 혼합 정밀도 (FP16/8) 적용 - 더 크거나 여러 개의 GPU 사용 |

-

커뮤니케이션 요구사항을 결정하세요

- 다중 GPU 학습인가요? NVLink가 필요한가요? 아니면 PCIe로 충분한가요?

-

예산에 맞추세요

- 최대 가격/성능을 원한다면: RTX 4090

- 메모리에 민감하지만 적절한 예산이라면: A6000

- 대용량 메모리와 최첨단 성능을 원한다면: RTX 6000 Ada

-

장기적인 연구 방향 고려

- 향후 더 큰 모델을 사용할 가능성이 있는 진화하는 연구 요구사항에는 더 높은 메모리 옵션을 선택하세요.

실용적인 배포 팁

- 학술 연구를 위해 구매 시, 정산/환불을 위해 판매사로부터 정식 증빙 서류(예: 세금계산서/계산서)를 받을 수 있는지 확인하세요.

- 다양한 워크로드가 예상되는 경우 이종 구성(heterogeneous setups)을 고려하세요.

- 다중 카드 시스템의 경우, 실험 실행 시

CUDA_VISIBLE_DEVICES로 사용할 카드를 명시하세요. 표: 다중 GPU 관리에서CUDA_VISIBLE_DEVICES의 역할. 이 표는 이 변수가 어떻게 작동하는지, 왜 유용한지, 그리고 GPU 할당 및 효율성을 개선하는 시나리오를 보여줍니다.

| 측면 | 설명 |

|---|---|

| 기능 | 프로세스에 보이는 GPU 제어 |

| 예시 구문 | CUDA_VISIBLE_DEVICES=0,1 python train.py — GPU 0과 1만 사용 |

| 장치 재매핑 | 나열된 장치를 내부적으로 논리 ID(예: 0이 cuda:0 됨)로 재매핑 |

| 격리 | 공유 GPU 서버에서 동시 작업 또는 사용자 간 중복 방지 |

| 성능 최적화 | 작업 부하 분산을 위한 세밀한 GPU 할당 가능 |

| 분산 학습 | 노드 또는 워커별 올바른 GPU 할당에 필수적 |

| 디버깅/테스트 | 특정 GPU에서 코드 테스트 또는 불량 GPU 회피에 유용 |

| 동적 GPU 사용 | 코드 수정 없이 스크립트가 다른 GPU 세트에서 실행 가능케 함 |

- 구매 전에 실제 작업 부하를 철저히 테스트하여 실제 메모리 요구사항을 파악하세요.

이러한 요소들을 특정 연구 요구사항 및 예산 제약과 비교하여 신중하게 평가함으로써, 딥러닝 및 LLM 개발 환경에 가장 적합한 GPU 솔루션을 선택할 수 있습니다.